你可能听过以下犀利的观点:

1.跟着NVIDIA的技术路线,可能永远也追不上NVIDIA的脚步。

2. DSA或许有机会追赶上NVIDIA,但目前的状况是DSA濒临消亡,看不到任何希望

另一方面,我们都知道现在大模型正处于风口位置,业界很多人想做大模型芯片,也有很多人想投大模型芯片。

但是,大模型芯片的设计关键在哪,大带宽大内存的重要性好像大家都知道,但做出来的芯片跟NVIDIA相比,又有何不同?

带着问题,本文尝试给大家一点启发。

纯粹以观点为主的文章往往显得形式主义,我们可以通过一个架构的例子来说明

SambaNova Systems被誉为美国十大独角兽公司之一。在2021年4月,该公司由软银牵头获得了6.78亿美元的D轮投资,估值达到了50亿美元,成为了一家超级独角兽公司。此前,SambaNova的投资方包括谷歌风投、Intel Capital、SK和Samsung催化基金等全球顶级风投基金。那么,这家吸引了全球顶级投资机构青睐的超级独角兽公司到底在做什么颠覆性的事情呢?通过观察他们早期的宣传材料,我们可以发现SambaNova选择了一条与AI巨头NVIDIA不同的发展道路

☞☞☞AI 智能聊天, 问答助手, AI 智能搜索, 免费无限量使用 DeepSeek R1 模型☜☜☜

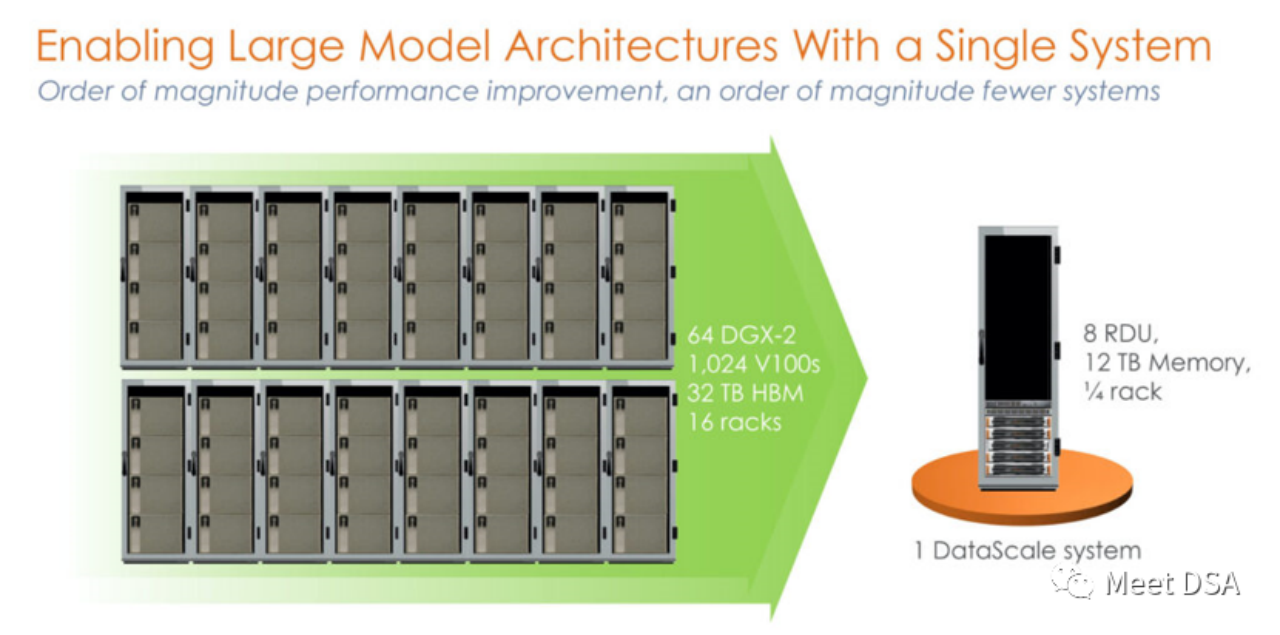

是不是有点震撼?在英伟达平台上用洪荒之力所构建的一个1024的V100集群,居然被SambaNova的一个单机就等价了?!这是第一代的产品,基于SN10 RDU的单机8卡机器。

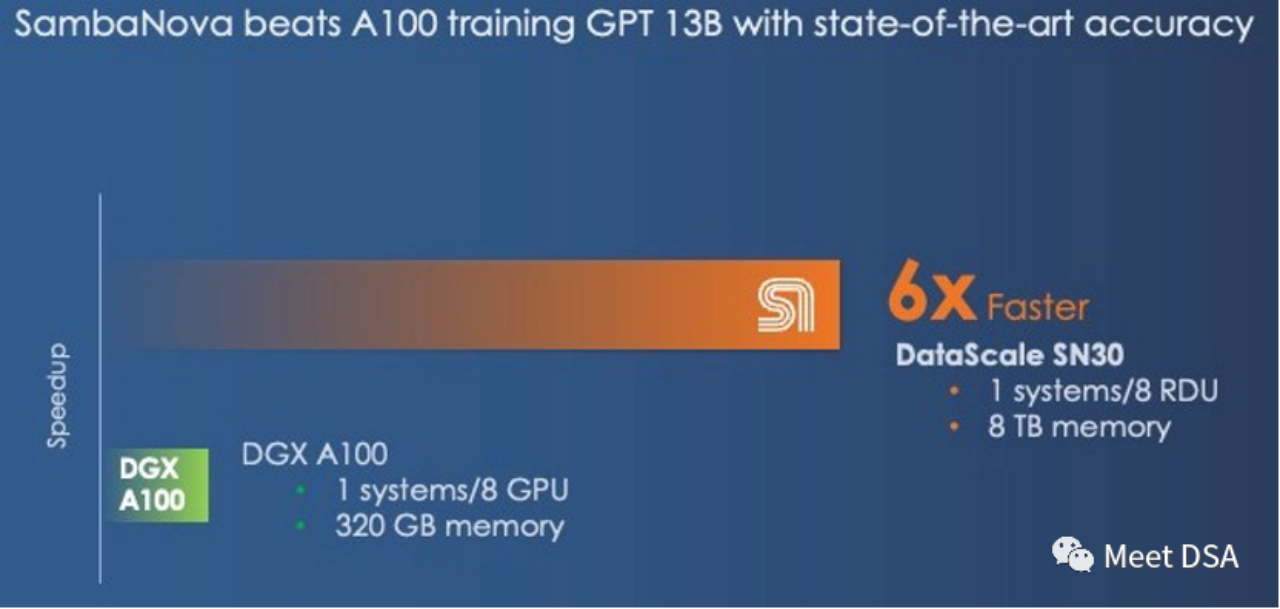

可能有人会说这个对比显得不太公平,NVIDIA不是有DGX A100吗,可能SambaNova自己也意识到了,二代产品SN30就改成这样了:

DGX A100 是5 petaFLOPS的算力,SambaNova的第二代DataScale的算力也是5 petaFLOPS。Memory对比320GB HBM vs 8TB DDR4(小编猜测可能他文章写错了,应该是3TB * 8)。

第二代芯片实际上是SN10 RDU的Die-to-Die版本。SN10 RDU的架构指标为:320TFLOPS@BF16,320M SRAM,1.5T DDR4。而SN30 RDU则是在此基础上进行了双倍的提升,正如下面所描述的那样:

“This chip had 640 pattern compute units with more than 320 teraflops of compute at BF16 floating point precision and also had 640 pattern memory units with 320 MB of on-chip SRAM and 150 TB/sec of on-chip memory bandwidth. Each SN10 processor was also able to address 1.5 TB of DDR4 auxiliary memory.”“With the Cardinal SN30 RDU, the capacity of the RDU is doubled, and the reason it is doubled is that SambaNova designed its architecture to make use of multi-die packaging from the get-go, and in this case SambaNova is doubling up the capacity of its DataScale machines by cramming two new RDU – what we surmise are two tweaked SN10s with microarchitectures changes to better support large foundation models – into a single complex called the SN30. Each socket in a DataScale system now has twice the compute capacity, twice the local memory capacity, and twice the memory bandwidth of the first generations of machines.”

要点提炼:大带宽,大容量只能二选一,NVIDIA选择了大带宽 HBM,而SambaNova选择了大容量 DDR4。从性能效果看,SambaNova完胜。

如果换成DGX H100,即使是换成FP8这些低精度的技术,也只能缩小差距。

“And even if the DGX-H100 offers 3X the performance at 16-bit floating point calculation than the DGX-A100, it will not close the gap with the SambaNova system. However, with lower precision FP8 data, Nvidia might be able to close the performance gap; it is unclear how much precision will be sacrificed by shifting to lower precision data and processing.”

如果有人能够实现这样的效果,那不就是一个完美的大型芯片解决方案吗?而且还能够直接面对NVIDIA的竞争!

(可能你会说Grace CPU也可以接LPDDR,利于增大容量之类的,反观SambaNova是怎么看这个事情:Grace不过是一个大号的内存控制器,但也只能给Hopper带来512GB的DRAM,而一个SN30就有3TB的DRAM。

我们曾经开玩笑说Nvidia的“Grace” Arm CPU只是Hopper GPU的一个过分夸大的内存控制器。在很多情况下,它确实只是一个内存控制器,而且每个Grace-Hopper超级芯片套装中的Hopper GPU最多只有512GB的内存。这仍然比SambaNova每个插槽提供的3TB内存要少很多

历史告诉我们,再如日中天的帝国,可能也要当心那道不起眼的裂缝!

夏核,华为大神,最近从成本的角度出发,推测了NVIDIA帝国的一个弱点可能在于每GB的成本上,他建议疯狂堆料廉价的DDR内存来进行大规模的内部输入/输出,这有可能对NVIDIA产生革命性的影响

(引申:https://www.php.cn/link/617974172720b96de92525536de581fa)

而另外一个研究DSA的知乎大神mackler给出了他的观点,从$/GBps(数据搬移)的角度看,HBM性价比更高,因为LLM虽然对内存容量有比较大的需求,但对于内存带宽也有巨大的需求,训练需要大量的参数需要在DRAM来交换。

(引申:https://www.php.cn/link/a56ee48e5c142c26cf645b2cc23d78fc)

从SambaNova的架构例子来看,大容量廉价DDR是可以解决LLM的问题的,这印证了夏core的判断!但是mackler观点中对数据搬移的巨大带宽的需求也是问题所在,那SambaNova是如何解决的?

需要进一步理解RDU架构的特点,其实也很容易理解:

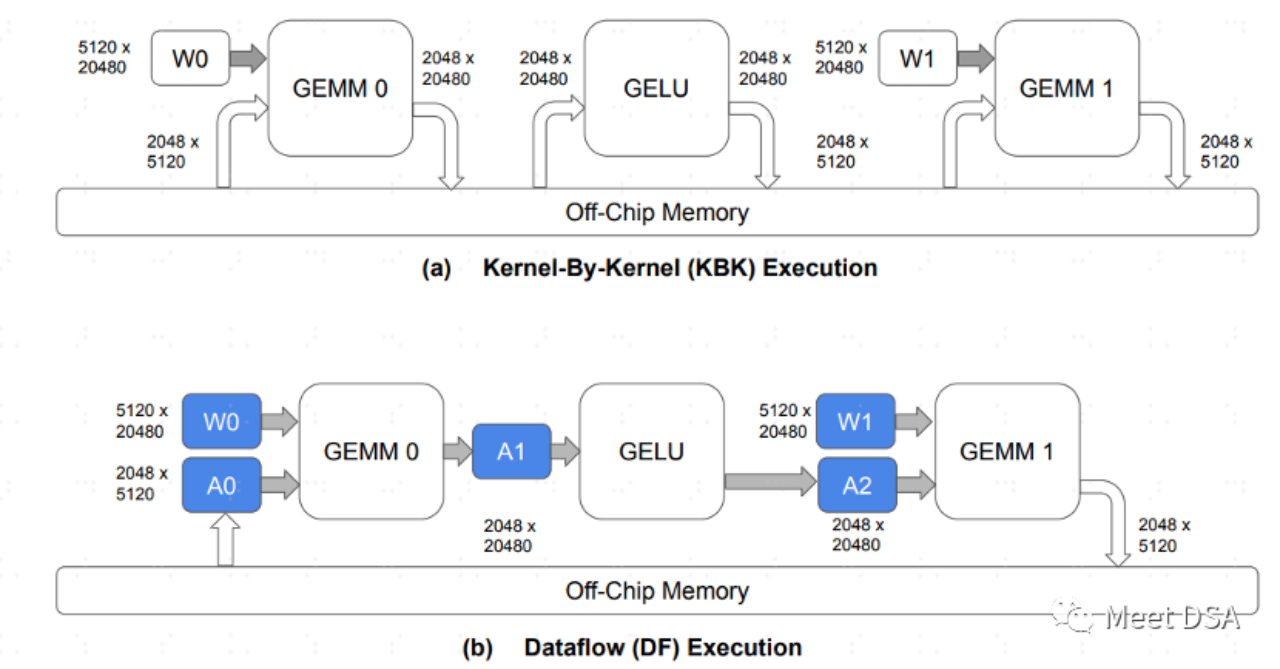

A是传统的GPU架构数据交换的范式,每个算子都需要去片外DRAM交换数据,这种来回的交换占据大量的DDR带宽应该比较好理解。B是SambaNova的架构可以做到的,模型计算过程,把很大部分的数据搬移都留在片内,不需要来回的去DRAM进行交换。

因此,如果能做到B这样的效果,大带宽,大容量二选一的问题,就可以安全的选大容量。这正如以下这段话所言:

“The question we have is this: What is more important in a hybrid memory architecture supporting foundation models, memory capacity or memory bandwidth? You can’t have both based on a single memory technology in any architecture, and even when you have a mix of fast and skinny and slow and fat memories, where Nvidia and SambaNova draw the lines are different.”

面对强大的NVIDIA,我们并非没有希望!然而,跟随NVIDIA进行GPGPU的策略可能并不可行。看起来,大型芯片的正确思路在于使用成本较低的DRAM,以相同的计算能力规格,性能可以达到NVIDIA的6倍以上!

SambaNova的RDU/DataFlow架构是如何实现B的效果的呢?或者是否有其他方法可以达到类似B的效果呢?我们将在下次与大家分享,有兴趣的朋友们请继续关注我们的更新

扩展阅读资料:

[1]https://sambanova.ai/blog/a-new-state-of-the-art-in-nlp-beyond-gpus/

[2]https://www.nextplatform.com/2022/09/17/sambanova-doubles-up-chips-to-chase-ai-foundation-models/

[3]https://hc33.hotchips.org/assets/program/conference/day2/SambaNova%20HotChips%202021%20Aug%2023%20v1.pdf

[4]《TRAINING LARGE LANGUAGE MODELS EFFICIENTLY WITH SPARSITY AND DATAFLOW》

[5]https://www.php.cn/link/617974172720b96de92525536de581fa

需要被改写的内容是:[6]https://www.php.cn/link/a56ee48e5c142c26cf645b2cc23d78fc