python multiprocessing.pool 默认调度策略是简单轮询+队列阻塞,任务入共享_inqueue,worker按需取用,无负载感知,易致头部阻塞。

进程池默认用什么调度策略?

Python 的 multiprocessing.Pool 默认用的是「任务窃取(work-stealing)」的变体,但实际表现更接近「简单轮询 + 队列阻塞」——它把任务放进一个共享的 self._inqueue,worker 进程按需从队列里拿,没有显式负载感知或优先级控制。

这意味着:任务分发不看 worker 当前忙闲,只看队列有没有空;如果某个任务耗时极长,后续短任务会被卡在它后面,造成“头部阻塞”。

- 所有 worker 共享一个输入队列,调度权在主进程,不是 worker 自主拉取

- 没有内置的 timeout、retry、优先级字段,也不支持动态调整并发数

-

apply_async()提交的任务顺序 ≠ 执行完成顺序,但入队顺序固定

怎么让短任务不被长任务拖住?

核心思路是拆开调度层和执行层:绕过默认队列,用 multiprocessing.Manager().Queue 或 concurrent.futures.ProcessPoolExecutor + 自定义提交逻辑,实现“就绪即投”。

更务实的做法是预估任务粒度,主动切分:

立即学习“Python免费学习笔记(深入)”;

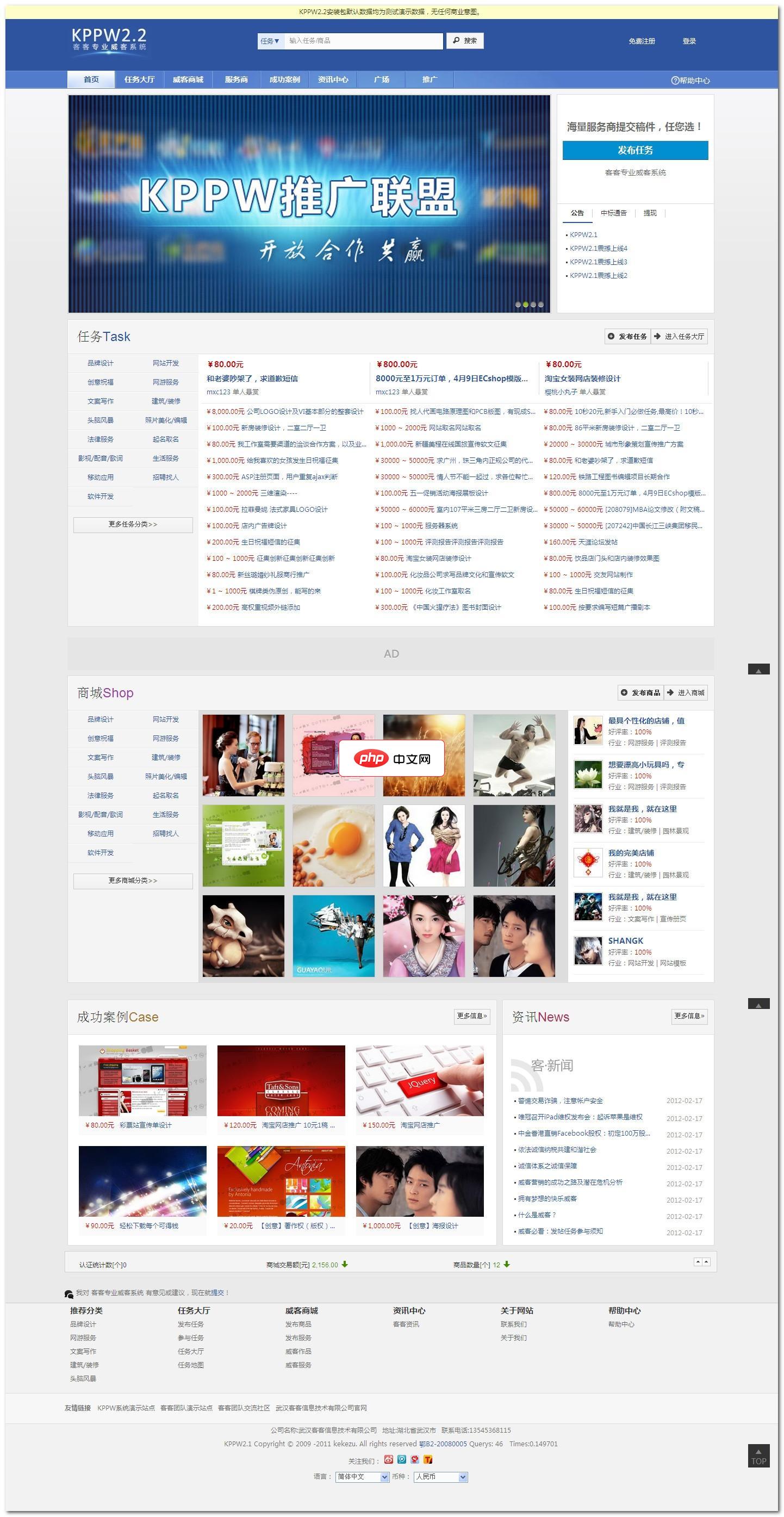

客客出品专业威客系统英文名称KPPW,也是keke produced professional witkey的缩写。KPPW是一款基于PHP+MYSQL技术构架的威客系统,积客客团队多年实践和对威客模式商业化运作的大量调查分析而精心策划研发,是您轻松搭建威客网站的首选利器。KPPW针对威客任务和商品交易模式进行了细致的分析,提供完善威客任务流程控制解决方案,并将逐步分享威客系统专业化应用作为我们的

- 把一个长任务手动拆成多个等效子任务,用

map_async()提交,避免单个apply_async()占满一个 worker - 对 I/O 型长任务(如下载),改用

asyncio.to_thread()+ProcessPoolExecutor混合调度,把 CPU 密集部分单独进进程池 - 不要依赖

maxtasksperchild=1来“公平”,它只防内存泄漏,不改善调度延迟

为什么 chunksize 参数会影响实际调度行为?

chunksize 不是并发数,而是 map 类操作(如 pool.map())向每个 worker 一次性推送的任务块大小。它直接决定任务分发节奏和 worker 空闲时间。

设总任务数为 100,worker 数为 4:

-

chunksize=1→ 每个 worker 拿 1 个任务,执行完立刻回队列抢下一个,调度最细,但 IPC 开销大 -

chunksize=25→ 每个 worker 一次性拿 25 个,内部 for 循环执行,期间完全不参与调度,可能造成其他 worker 空转 - 默认值是

max(1, len(iterable) // (4 * processes)),适合均匀任务;若任务耗时差异大,必须手动设小值(如 1 或 2)

遇到 “BrokenPipeError: [Errno 32] Broken pipe” 怎么定位?

这通常不是调度策略问题,而是 worker 异常退出后,主进程还往已关闭的 _inqueue 写数据。根本原因是:某个 worker 因未捕获异常(如 MemoryError、段错误、信号终止)提前死亡,但主进程没感知,继续投任务。

- 检查 worker 函数是否吞掉了顶层异常(尤其

try...except:无日志) - 用

pool.apply_async(..., error_callback=lambda e: print(e))捕获子进程报错 - 避免在 worker 中调用

os._exit()或触发 core dump 的 C 扩展;改用正常 return 或抛出可序列化异常 -

Pool不自动重启失败 worker,一旦发生 BrokenPipe,整个池基本不可再用,得重建

调度本身不复杂,难的是任务特征和 worker 稳定性之间的匹配。很多人卡在“为什么明明开了 8 个进程,CPU 却只跑 120%”,其实不是调度器的问题,是任务没真正并行——比如全在等同一个锁,或者共享了未加锁的全局状态。