本篇文章给大家带来了关于python的相关知识,其中主要整理了爬虫解析器beautifulsoup4的相关问题,beautiful soup是一个可以从html或xml文件中提取数据的python库,它能够通过你喜欢的转换器实现惯用的文档导航、查找、修改文档的方式,下面一起来看一下,希望对大家有帮助。

【相关推荐:Python3视频教程 】

一、BeautifulSoup4库介绍

1. 介绍

Beautiful Soup 是一个可以从HTML或XML文件中提取数据的Python库.它能够通过你喜欢的转换器实现惯用的文档导航,查找,修改文档的方式.Beautiful Soup会帮你节省数小时甚至数天的工作时间。

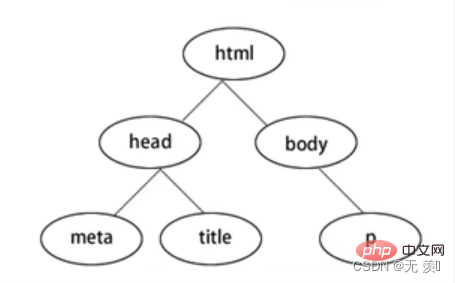

BeautifulSoup4将网页转换为一颗DOM树:

2. 下载模块

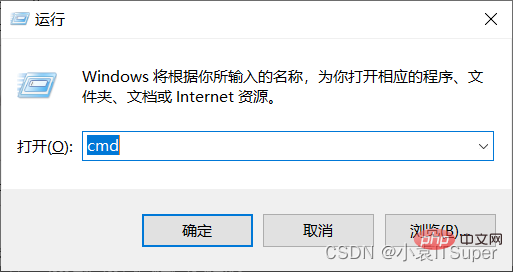

1. window电脑点击win键+ R,输入:cmd

立即学习“Python免费学习笔记(深入)”;

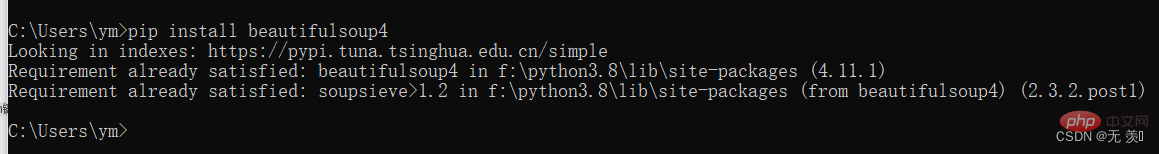

2. 安装beautifulsoup4,输入对应的pip命令:pip install beautifulsoup4 ,我已经安装过了出现版本就安装成功了

3. 导包

form bs4 import BeautifulSoup

3. 解析库

BeautifulSoup在解析时实际上依赖解析器,它除了支持Python标准库中的HTML解析器外,还支持一 些第三方解析器(比如lxml):

| 解析器 | 使用方法 | 优势 | 劣势 |

|---|---|---|---|

| Python标准库 | BeautifulSoup(html,’html.parser’) |

Python的内置标准库、执行速度适中、文档容错能力强 | Python 2.7.3及Python3.2.2之前的版本文档容错能力差 |

| lxml HTML解析库 | BeautifulSoup(html,’lxml’) |

速度快、文档容错能力强 | 需要安装C语言库 |

| lxml XML解析库 | BeautifulSoup(html,‘xml' |

速度快、唯一支持XML的解析器 | 需要安装C语言库 |

| htm5lib解析库 | BeautifulSoup(html,’htm5llib’) |

最好的容错性、以浏览器的方式解析文档、生成HTMLS格式的文档 | 速度慢、不依赖外部扩展 |

对于我们来说,我们最常使用的解析器是lxml HTML解析器,其次是html5lib.

二、上手操作

1. 基础操作

1. 读取HTML字符串:

from bs4 import BeautifulSoup html = '''

Hello

- Foo

- Bar

- Jay

- Foo 百度官网

- Bar

2. 读取HTML文件:

from bs4 import BeautifulSoup

soup = BeautifulSoup(open('index.html'),'lxml')3. 基本方法

from bs4 import BeautifulSoup html = '''

Hello

- Foo

- Bar

- Jay

- Foo 百度官网

- Bar

2. 对象种类

Beautiful Soup将复杂HTML文档转换成一个复杂的树形结构,每个节点都是Python对象,所有对象可以归纳为4种: Tag , NavigableString , BeautifulSoup , Comment .

(1)Tag:Tag通俗点讲就是HTML中的一个个标签,例如:

soup = BeautifulSoup('Extremely bold','lxml')

tag = soup.b

print(tag)

print(type(tag))输出结果:

Extremely bold

Tag有很多方法和属性,在 遍历文档树 和 搜索文档树 中有详细解释.现在介绍一下tag中最重要的属性: name和attributes:

name属性:

print(tag.name) # 输出结果:b # 如果改变了tag的name,那将影响所有通过当前Beautiful Soup对象生成的HTML文档: tag.name = "b1" print(tag) # 输出结果:Extremely bold

Attributes属性:

# 取clas属性 print(tag['class']) # 直接”点”取属性, 比如: .attrs : print(tag.attrs)

tag 的属性可以被添加、修改和删除:

# 添加 id 属性 tag['id'] = 1 # 修改 class 属性 tag['class'] = 'tl1' # 删除 class 属性 del tag['class']

(2)NavigableString:用.string获取标签内部的文字:

print(soup.b.string)print(type(soup.b.string))

(3)BeautifulSoup:表示的是一个文档的内容,可以获取它的类型,名称,以及属性:

print(type(soup.name)) #print(soup.name) # [document] print(soup.attrs) # 文档本身的属性为空

(4)Comment:是一个特殊类型的 NavigableString 对象,其输出的内容不包括注释符号。

print(soup.b) print(soup.b.string) print(type(soup.b.string))

3. 搜索文档树

1.find_all(name, attrs, recursive, text, **kwargs)

(1)name 参数:name 参数可以查找所有名字为 name 的tag,字符串对象会被自动忽略掉

-

匹配字符串:查找与字符串完整匹配的内容,用于查找文档中所有的

标签a_list = soup.find_all("a")print(a_list) -

匹配正则表达式:如果传入正则表达式作为参数,Beautiful Soup会通过正则表达式的 match() 来匹配内容

# 返回所有表示和标签for tag in soup.find_all(re.compile("^b")): print(tag.name) -

匹配列表:如果传入列表参数,Beautiful Soup会将与列表中任一元素匹配的内容返回

# 返回所有所有

(2)kwargs参数

soup.find_all(id='link2')

(3)text参数:通过 text 参数可以搜搜文档中的字符串内容,与 name 参数的可选值一样, text 参数接受 字符串 , 正则表达式 , 列表

# 匹配字符串

soup.find_all(text="a")

# 匹配正则

soup.find_all(text=re.compile("^b"))

# 匹配列表

soup.find_all(text=["p", "a"])4. css选择器

我们在使用BeautifulSoup解析库时,经常会结合CSS选择器来提取数据。

注意:以下讲解CSS选择器只选择标签,至于获取属性值和文本内容我们后面再讲。

1. 根据标签名查找:比如写一个 li 就会选择所有li 标签, 不过我们一般不用,因为我们都是精确到标签再提取数据的

from bs4 import BeautifulSoup html = '''

Hello

- Foo

- Bar

- Jay

- Foo 百度官网

- Bar

输出结果:

[

2. 根据类名class查找。.1ine, 即一个点加line,这个表达式选的是class= "line "的所有标签,".”代表class

print(soup.select(".panel_body"))输出结果:

- Foo

- Bar