本文介绍在 go 并发编程中,如何通过中间协调层+通道选择机制(select + nil channel trick)实现相同 id 任务的自动合并执行,避免重复昂贵计算,同时规避死锁风险,无需显式 mutex 即可保证线程安全。

本文介绍在 go 并发编程中,如何通过中间协调层+通道选择机制(select + nil channel trick)实现相同 id 任务的自动合并执行,避免重复昂贵计算,同时规避死锁风险,无需显式 mutex 即可保证线程安全。

在高并发场景下,当多个 goroutine 提交语义相同(如相同 TaskID)但需独立响应的任务时,若每个任务都触发一次昂贵计算(如数据库聚合、远程 API 调用、模型推理),系统资源将被严重浪费。理想方案是:首次收到某 ID 任务时启动计算,后续同 ID 任务暂存并共享结果——即“任务合并”(Task Coalescing)。Go 原生并无专用数据结构支持该模式,但可通过通道组合与精巧的控制流优雅实现。

核心思路:解耦提交、执行与分发

关键在于引入一个无锁协调器 goroutine,它不直接执行任务,而是承担三重职责:

- 接收新任务,按 ID 归集(map[TaskID][]*Task);

- 当发现某 ID 首次出现时,将其转发至工作池;

- 接收计算结果后,广播给所有同 ID 的等待任务。

最简实现如下(含基础防死锁设计):

type Task struct {

ID string

Result chan *TaskResult

}

type TaskResult struct {

ID string

Value interface{}

}

// 启动协调器

func startCoalescer(queue <-chan *Task, worker chan<- *Task, response <-chan *TaskResult) {

active := make(map[string][]*Task)

for {

select {

case task := <-queue:

// 归集任务

active[task.ID] = append(active[task.ID], task)

// 若为首个同 ID 任务,触发执行

if len(active[task.ID]) == 1 {

worker <- task // 注意:此处存在潜在阻塞风险(见后文)

}

case r := <-response:

// 广播结果并清空归集

if tasks, ok := active[r.ID]; ok {

for _, t := range tasks {

t.Result <- r

}

delete(active, r.ID)

}

}

}

}⚠️ 注意:上述版本存在经典死锁隐患。当 worker 通道满或处理缓慢时,协调器在 worker

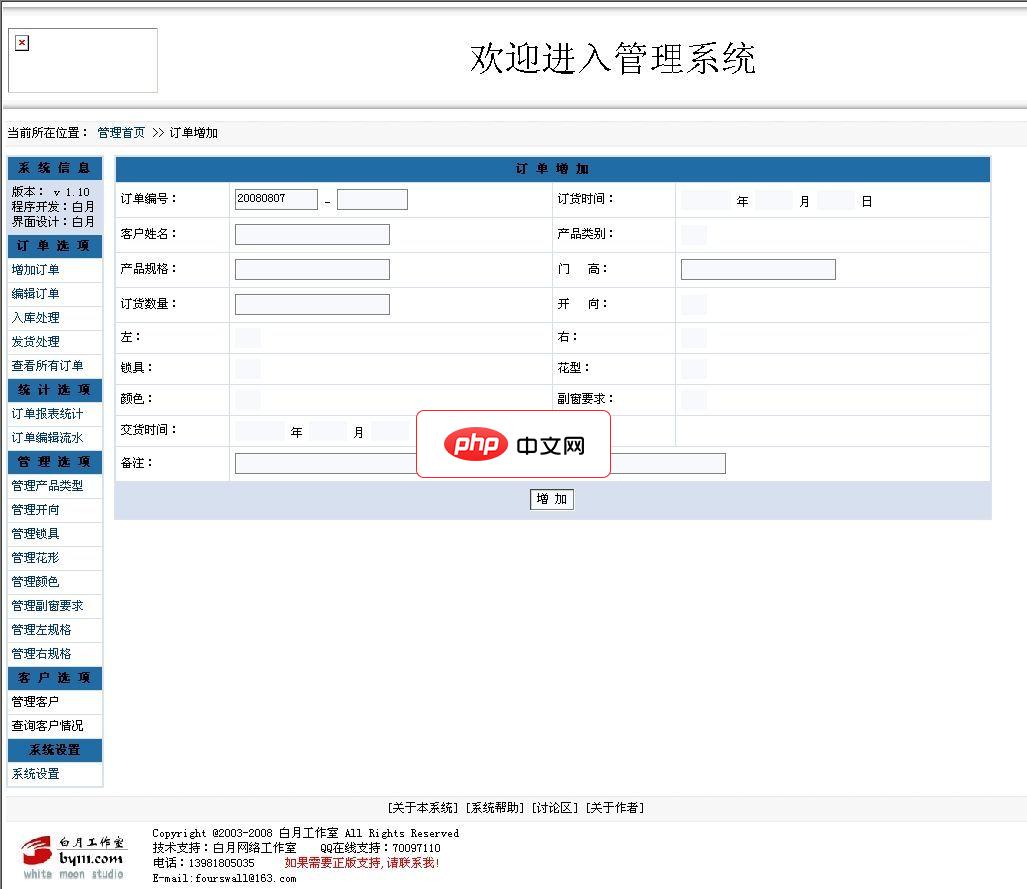

请注意以下说明:1、本程序允许任何人免费使用。2、本程序采用PHP+MYSQL架构编写。并且经过ZEND加密,所以运行环境需要有ZEND引擎支持。3、需要售后服务的,请与本作者联系,联系方式见下方。4、本程序还可以与您的网站想整合,可以实现用户在线服务功能,可以让客户管理自己的信息,可以查询自己的订单状况。以及返点信息等相关客户利益的信息。这个功能可提高客户的向心度。安装方法:1、解压本系统,放在

进阶方案:使用 nil channel trick 实现非阻塞调度

为彻底消除阻塞点,可利用 Go 中 nil channel 在 select 中永不就绪的特性,动态切换通道状态,确保协调器始终能响应任一事件:

func startCoalescerSafe(queue <-chan *Task, worker chan<- *Task, response <-chan *TaskResult, collect chan<- *TaskResult) {

var next *Task

in := queue

var out chan<- *Task // 初始为 nil,使 send 分支不可选

for {

select {

case task := <-in:

// 收到新任务:暂存,并切换为向 worker 发送

next = task

in, out = nil, worker // 关闭接收,开启发送

case out <- next:

// 成功发送后:恢复接收,关闭发送

next = nil

in, out = queue, nil

case r := <-response:

// 独立响应通道:直接转发至收集器(可另起 goroutine 处理)

collect <- r

}

}

}

// 使用示例

func main() {

queue := make(chan *Task, 100)

worker := make(chan *Task, 10)

response := make(chan *TaskResult, 10)

collect := make(chan *TaskResult, 100)

// 启动协调器(安全版)

go startCoalescerSafe(queue, worker, response, collect)

// 启动结果分发器(独立 goroutine,避免阻塞协调器)

go func() {

active := make(map[string][]*Task)

for r := range collect {

if tasks, ok := active[r.ID]; ok {

for _, t := range tasks {

t.Result <- r

}

delete(active, r.ID)

}

}

}()

// 启动工作池(示例:单个 worker)

go func() {

for task := range worker {

result := doExpensiveComputation(task)

response <- &TaskResult{ID: task.ID, Value: result}

}

}()

}该模式优势显著:

- ✅ 零 mutex:归集映射 active 仅由单 goroutine 访问,天然线程安全;

- ✅ 无死锁:select 动态启停通道,确保任意时刻至少有一个分支可就绪;

- ✅ 可扩展:collect 通道可接入缓存层(如 LRU)、去重逻辑或异步落库;

- ✅ 职责清晰:协调器专注路由,worker 专注计算,分发器专注广播。

最佳实践建议

- 缓冲通道合理设置:queue、worker、response 均需配置适当缓冲(如 make(chan, N)),避免瞬时洪峰导致 goroutine 阻塞;

- 超时与取消支持:为 task.Result 添加 context.WithTimeout,防止客户端无限等待;

- 结果缓存增强:若相同 ID 任务高频重复,可在 collect 流程中加入内存缓存(如 sync.Map),对近期结果直接返回;

- 监控可观测性:记录每秒合并任务数、平均等待延迟、缓存命中率等指标,便于容量规划。

任务合并不是银弹,它适用于读多写少、ID 空间有限、计算代价远高于协调开销的场景。正确实现后,你将获得线性可伸缩的吞吐能力提升——而这正是 Go 并发哲学的精髓:用通道组合代替锁竞争,以控制流设计化解状态同步难题。