deepcoder-14b-preview:一款开源的140亿参数代码生成模型

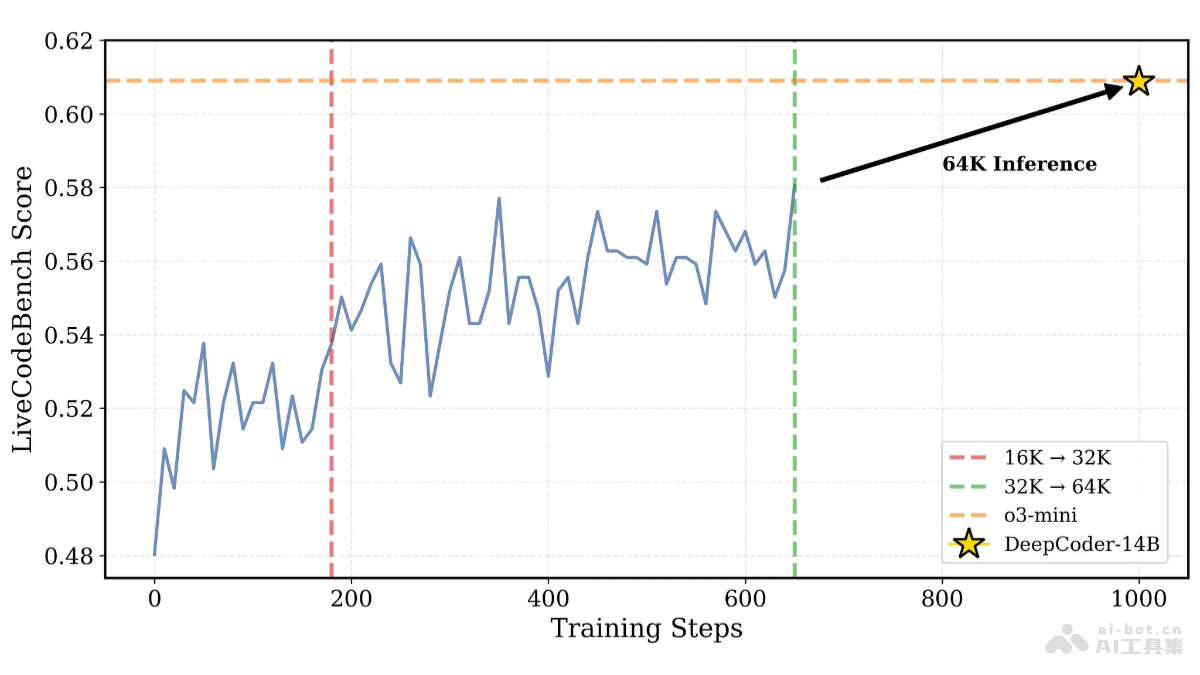

Agentica和Together AI联合发布了DeepCoder-14B-Preview,这是一个基于Deepseek-R1-Distilled-Qwen-14B微调的大型代码生成模型。该模型采用分布式强化学习(RL)训练,在代码生成任务上表现优异,尤其在LiveCodeBench基准测试中取得了60.6%的准确率,与OpenAI的o3-mini模型不相上下。 更重要的是,其训练数据集、代码、训练日志和系统优化方案均已开源,旨在降低RL训练门槛,促进社区发展和强化学习在大型语言模型(LLM)领域的应用。

☞☞☞AI 智能聊天, 问答助手, AI 智能搜索, 免费无限量使用 DeepSeek R1 模型☜☜☜

核心功能:

- 高效代码生成: 生成高质量、可执行的代码,支持多种编程语言和应用场景。

- 代码问题解决: 协助解决复杂的编程难题,包括算法设计和数据结构优化等。

- 代码补全与优化: 提供代码自动补全,提升编码效率,并优化现有代码。

- 单元测试生成: 自动生成单元测试代码,确保代码的准确性和可靠性。

- 代码调试辅助: 帮助开发者快速定位和修复代码错误。

- 跨平台兼容: 支持多种编程环境和平台。

技术架构:

DeepCoder-14B-Preview基于经过蒸馏优化的140亿参数预训练模型Deepseek-R1-Distilled-Qwen-14B,并通过分布式强化学习进行微调。其训练使用了24000个经过严格筛选的可验证编程问题,数据来源包括TACO Verified、PrimeIntellect的SYNTHETIC-1数据集以及LiveCodeBench。 模型采用稀疏结果奖励模型(ORM),仅在生成的代码通过所有采样单元测试时才给予奖励,避免模型依赖记忆测试用例。 此外,迭代上下文扩展技术和verl-pipeline流水线技术分别提升了模型的泛化能力和训练效率。

项目资源:

- 项目主页: https://www.php.cn/link/0d0dd06a746311e36ca0766cfe2b1b15

- HuggingFace模型库: https://www.php.cn/link/061f193d29d6ec5b5c02ed242396c2a7

应用场景:

- 代码自动化: 加速代码编写,提高开发效率。

- 算法竞赛: 辅助算法竞赛选手快速解决问题。

- 代码优化与重构: 提升代码质量和可维护性。

- 编程教育: 作为编程学习和教学辅助工具。

- 软件开发与测试: 辅助软件开发和测试流程。