加州大学伯克利分校吴梓阳博士及其团队提出了一种新型transformer架构——token statistics transformer (tost),其核心是线性时间复杂度的注意力机制。这项研究成果已发表在iclr 2025,并被选为spotlight论文。马毅教授将在今年四月iclr大会上进行主题报告。

☞☞☞AI 智能聊天, 问答助手, AI 智能搜索, 免费无限量使用 DeepSeek R1 模型☜☜☜

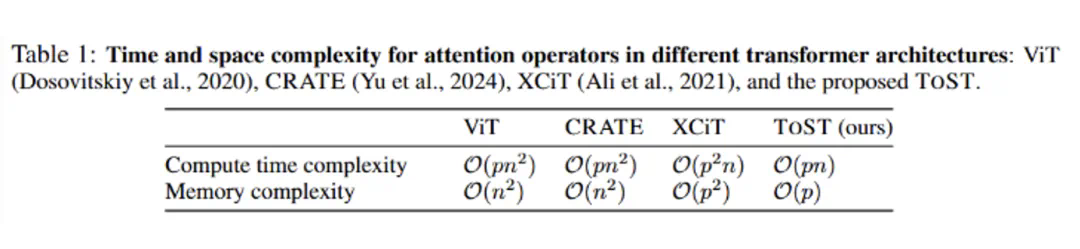

ToST巧妙地解决了传统Transformer架构中自注意力机制计算复杂度高的问题。传统自注意力机制的计算复杂度随输入token数量呈二次方增长,而ToST通过对序列特征的统计建模,将时间复杂度降低至线性。 这使得ToST能够高效处理更长序列和更大模型。

- 论文标题:Token Statistics Transformer: Linear-Time Attention via Variational Rate Reduction

- 论文地址:https://www.php.cn/link/95f8a41d276ddf36bcdc87d53627da29

- 项目主页:https://www.php.cn/link/c7f746b7939ba6db31093d4438d9207b

- 开源地址:https://www.php.cn/link/ef13ab03d0eb503ae378006c95daa368

核心创新:Token Statistics Self-Attention (TSSA)

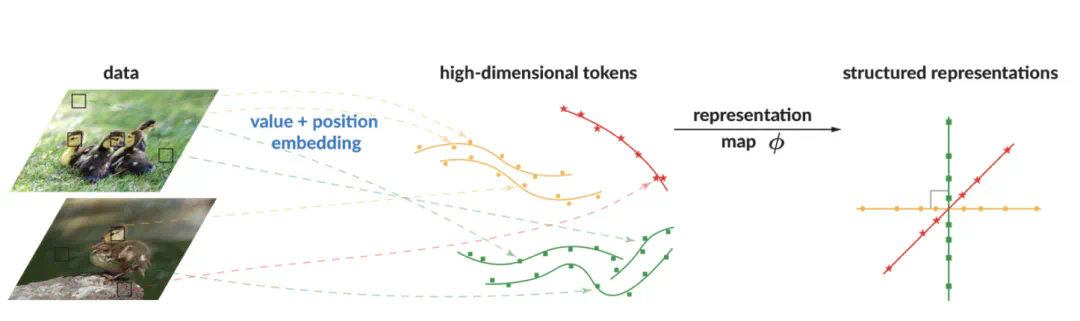

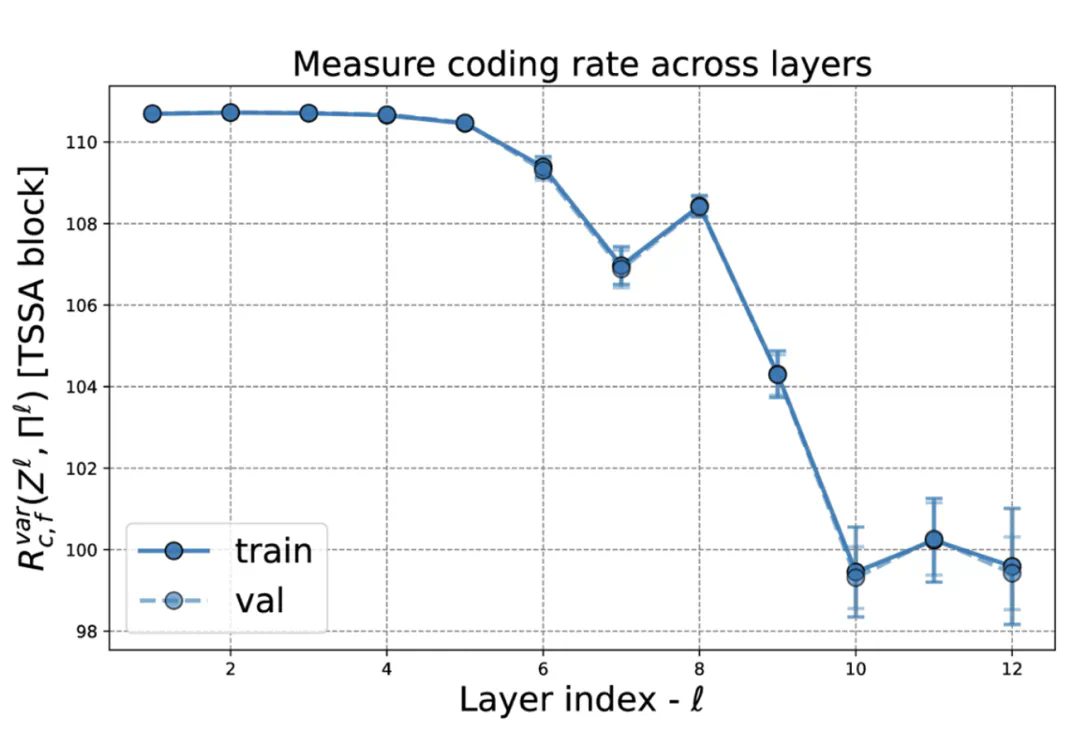

ToST的核心是TSSA,它通过避免两两相似性计算,仅依赖于token特征的统计量,从而实现线性复杂度。 该方法基于变分编码率缩减(Variational Rate Reduction, VRR)框架,并通过实验验证了其在不同任务上的有效性。

方法概述: ToST通过提取统计特征,利用VRR框架压缩特征,最终实现线性时间复杂度。 其架构基于先前CRATE工作的扩展,通过最大编码率缩减目标(MCR²)的变分形式推导得出。

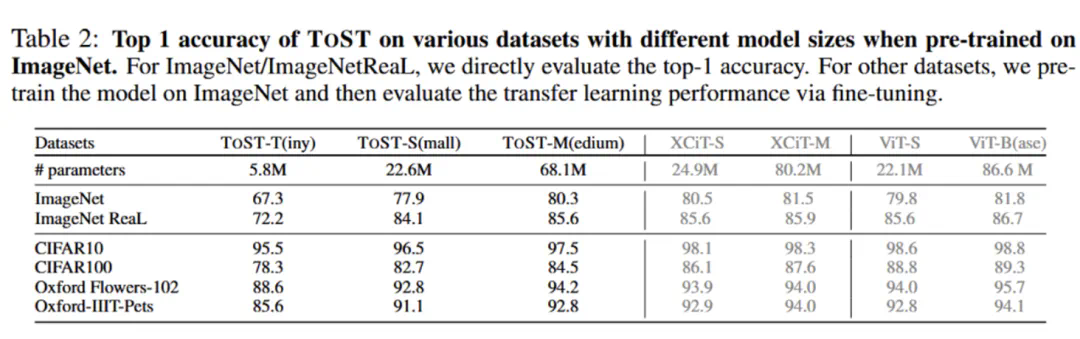

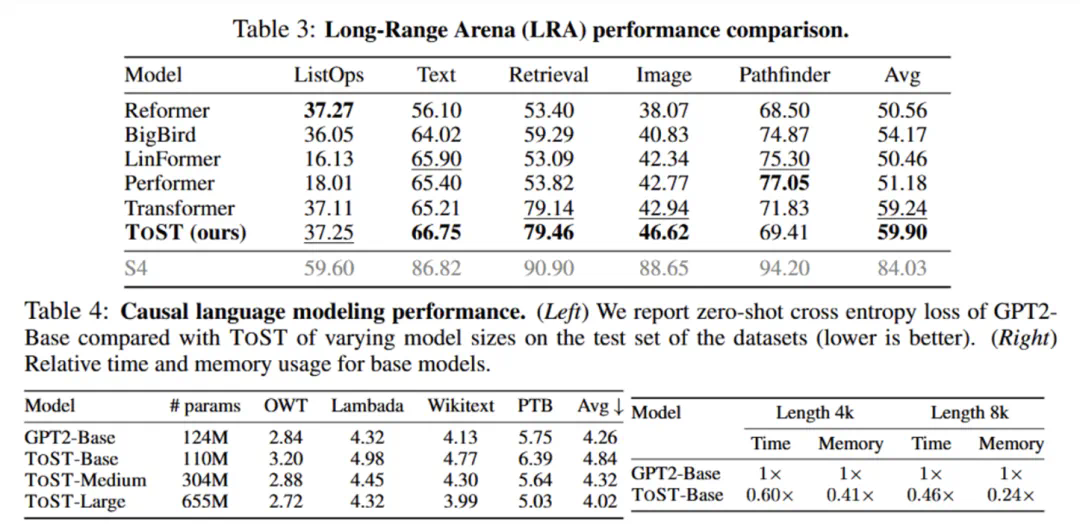

实验结果与性能分析: ToST在多个领域(NLP、CV)的任务中都取得了优异的成绩,同时显著降低了计算资源消耗。实验结果表明,ToST在计算时间和内存使用上均实现了线性扩展,且性能与传统Transformer架构相当甚至更好。

未来影响: ToST的线性时间复杂度注意力机制,为大模型的高效化、Transformer的普适化应用、多模态融合以及跨学科应用提供了新的可能性,具有重要的学术意义和应用价值。