ai大模型如今已逐渐成为许多人工作与生活中不可或缺的智能助手。但对于绝大多数非技术背景的普通用户来说,想要在自己的电脑上部署这些强大的ai模型,往往意味着要面对繁琐的命令行操作、复杂的环境配置以及令人头疼的代码调试过程。

那么,是否存在一种能让“零基础”用户也能轻松实现本地AI部署的工具?答案是肯定的。今天要介绍的这款应用,正是专为新手打造的一站式AI本地化解决方案。

AI本地化利器:【DS本地部署大师】

AI本地化利器:【DS本地部署大师】

简单来说,这是一款专为Windows系统设计的AI模型部署工具,其核心理念是将原本复杂的技术流程简化成“像安装普通软件一样”的一键操作。无论是DeepSeek、通义千问等主流大模型,都可以通过直观的图形界面快速安装并运行,无需了解背后的编程或系统配置细节。

它的主要优势包括:

立即进入“豆包AI人工智官网入口”;

立即学习“豆包AI人工智能在线问答入口”;

与Ollama等同类工具对比:

与Ollama等同类工具对比:

| 特性 | DS本地部署大师 | Ollama |

|---|---|---|

| 目标用户 | 零基础用户、办公人员 | 开发者、技术人员 |

| 安装难度 | 图形化向导,一键完成 | 需手动配置Python/CUDA,依赖命令行 |

| 交互方式 | 可视化对话窗口+功能按钮 | 命令行或API接口操作 |

| 多模型管理 | 支持多模型共存,可一键切换 | 需手动加载不同模型文件 |

| 联网能力 | 内置在线模型(如DeepSeek/文心一言)+实时搜索 | 需自行开发扩展功能 |

| 数据安全 | 本地优先,支持混合模式 | 纯本地运行 |

| 跨平台兼容性 | 目前仅支持Windows | 支持Windows/macOS/Linux |

| 适用场景 | 日常办公、快速体验、隐私敏感任务 | 二次开发、研究实验、定制项目 |

由此可见,相较于偏向技术用户的Ollama,这款工具更注重易用性和普适性,特别适合希望快速上手AI、又不想折腾技术细节的新手用户。

下面我们将一步步带你完成AI模型的本地部署全过程。

一、部署前准备

硬件与系统建议

由于大语言模型对计算资源要求较高,尤其是显卡性能至关重要。推荐使用配备NVIDIA显卡(建议RTX 20系列及以上,显存不少于8GB)的Windows电脑以获得流畅体验。具体配置参考如下图所示:

二、详细部署步骤

二、详细部署步骤

第一步:安装程序

前往官方站点下载最新版安装包,选择一个非系统盘路径进行安装(避免C盘空间不足),按照提示点击“下一步”或“立即安装”,几分钟内即可完成整个安装流程。

第二步:选择并部署AI模型

第二步:选择并部署AI模型

打开软件后,点击底部“下载模型”按钮,即可看到当前支持部署的AI模型列表,涵盖deepseek-r1系列、Qwen系列等多种热门模型。

每个模型旁边都会明确标注推荐的硬件配置,包括存储空间、内存大小、CPU型号和显存要求。如果你的设备性能较强,可以尝试部署更大参数规模的模型以获得更强的理解与生成能力。

每个模型旁边都会明确标注推荐的硬件配置,包括存储空间、内存大小、CPU型号和显存要求。如果你的设备性能较强,可以尝试部署更大参数规模的模型以获得更强的理解与生成能力。

选定所需模型后,点击“点击立即部署本地环境”,软件便会自动开始下载模型文件并完成环境配置。此过程耗时取决于网络速度和模型体积,请耐心等待进度条走完即可。

选定所需模型后,点击“点击立即部署本地环境”,软件便会自动开始下载模型文件并完成环境配置。此过程耗时取决于网络速度和模型体积,请耐心等待进度条走完即可。

第三步:开启AI对话之旅

第三步:开启AI对话之旅

部署成功后,软件会自动跳转至主对话界面。此时你可以在输入框中提问,与本地运行的AI进行自然交流。该工具同时支持本地模式、在线AI服务(如DeepSeek、千问、豆包、文心一言)以及联网检索功能,灵活应对各种使用场景。

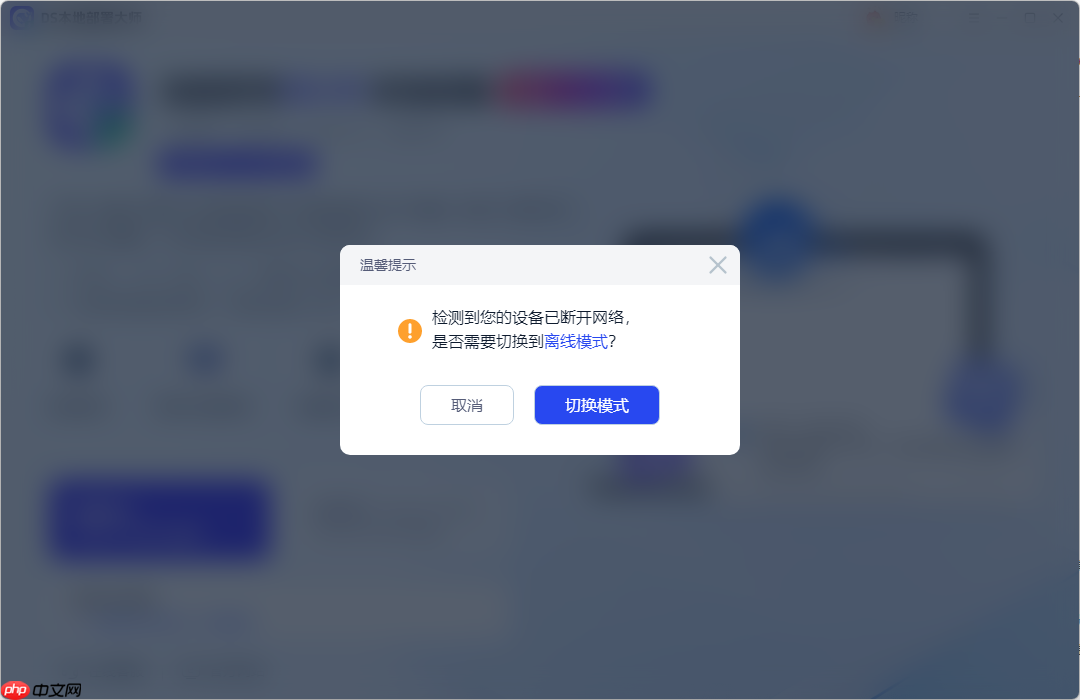

没有网络也能用吗?当然可以!当检测到设备断网时,软件会自动弹出提示窗口,只需点击“切换模式”,即可无缝进入离线AI对话状态,非常适合在飞机、高铁、地下停车场等无信号环境中使用。

没有网络也能用吗?当然可以!当检测到设备断网时,软件会自动弹出提示窗口,只需点击“切换模式”,即可无缝进入离线AI对话状态,非常适合在飞机、高铁、地下停车场等无信号环境中使用。

举个实际例子:

举个实际例子:

你可以向AI发出请求:“请帮我写一封内部邮件,主题是关于第三季度项目复盘会议的通知。需要强调会议的重要性和保密性,参会人员为项目部全体成员,时间定于下周三下午两点,地点在301会议室。”

AI会迅速理解需求,并生成结构清晰、语气得体的正式邮件内容。

借助这种极简化的操作方式,专业级的AI本地部署终于走进了每一位普通用户的桌面。如果你一直对本地AI感兴趣却苦于技术门槛过高,或者你在工作中急需一个安全可控的智能助手,那么这款“开箱即用”的工具值得你亲自尝试一番。

借助这种极简化的操作方式,专业级的AI本地部署终于走进了每一位普通用户的桌面。如果你一直对本地AI感兴趣却苦于技术门槛过高,或者你在工作中急需一个安全可控的智能助手,那么这款“开箱即用”的工具值得你亲自尝试一番。

以上就是小白看过来——适合初学者的AI部署工具,开箱即用的详细内容,更多请关注php中文网其它相关文章!

解决渣网、解决锁区、快速下载数据、时刻追新游,现在下载,即刻拥有流畅网络。

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号