NativeMind:本地运行的AI助手

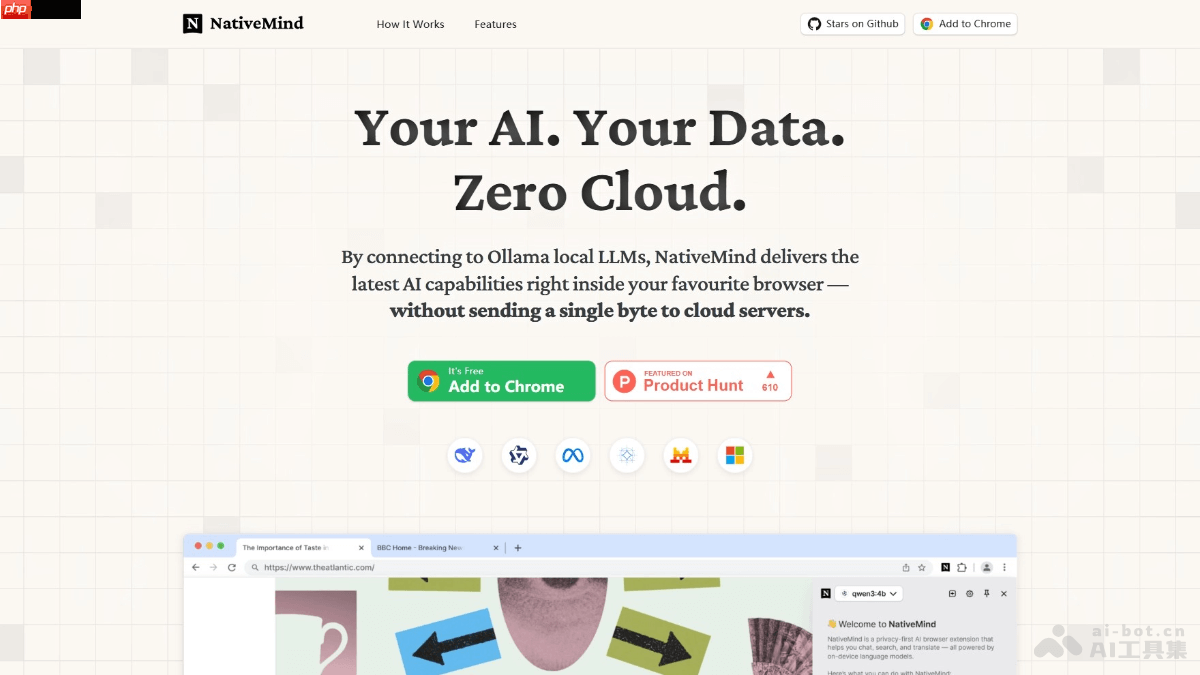

nativemind是一款开源、完全在设备本地运行的ai助手工具。它支持多种模型,包括deepseek、qwen和llama等,并通过ollama实现无缝集成与切换。nativemind提供智能对话、网页内容分析、翻译、写作辅助等功能,全部在浏览器中完成,无需依赖云端同步。其最大的特点在于100%本地化数据处理,无云依赖、无追踪、无日志记录,保障用户对数据的完全控制权。

☞☞☞AI 智能聊天, 问答助手, AI 智能搜索, 免费无限量使用 DeepSeek R1 模型☜☜☜

NativeMind的核心功能

-

多标签上下文对话:具备多标签页上下文理解能力,可进行深入的AI对话,整合多个页面的信息,使交流更连贯自然。

-

网页内容提炼:能够即时总结网页信息,提取关键内容;同时支持文档解析,帮助用户快速掌握核心要点,节省阅读时间。

-

全页翻译与选段翻译:提供整页翻译功能,支持双语对照显示,便于查看对比;也可对特定文本进行翻译,满足多样化需求。

-

智能搜索增强:强化浏览器搜索功能,在输入问题后,NativeMind将自动浏览网页并返回精准答案,提升搜索效率。

-

文本优化辅助:自动识别文本内容,提供改写建议、语法校对及创意灵感,协助用户提升写作质量。

-

动态上下文工具栏:在浏览网页时,根据当前内容动态显示浮动操作栏,提供翻译、摘要等功能按钮,方便随时调用。

NativeMind的技术架构

-

本地AI模型执行:NativeMind的所有AI运算均在用户设备上完成,不依赖任何远程服务器,确保数据隐私与安全。

-

Ollama平台集成:与Ollama深度整合,后者是一个本地AI模型管理平台,支持如DeepSeek、Qwen、Llama、Gemma、Mistral等多种主流模型,用户可根据需要自由切换。

-

WebLLM技术支撑:NativeMind兼容WebLLM,这是一种基于WebAssembly的轻量级AI模型,可直接在浏览器中运行,无需额外安装软件。

-

浏览器扩展结构:NativeMind通过Chrome Web Store等渠道发布,基于浏览器扩展API与用户界面交互。前端采用Vue 3与TypeScript构建,提供流畅的操作体验;后端则利用WebLLM与Ollama的接口与本地AI模型通信,处理输入与输出。通信机制使用WebSockets或其他高效协议,与本地Ollama服务器保持实时连接,确保响应迅速且传输稳定。

NativeMind的官方资源

NativeMind的典型用途

-

学术研究辅助:帮助学生和研究人员快速获取文献重点,结合多标签上下文理解功能整合不同资料,提高研究效率。

-

企业文档优化:员工可利用内容分析功能快速掌握文档主旨,并借助写作增强工具优化语言表达,提升文档专业性。

-

在线学习支持:学习者通过通用翻译功能跨越语言障碍,配合实时辅助功能获取资料摘要或重点讲解,深化知识吸收。

-

市场情报整理:市场分析师可在本地环境中快速检索信息,结合内容分析功能整理调研结果,高效生成分析报告。

-

个人知识体系构建:用户可通过跨标签对话记录想法与解答,整合多来源信息,打造个性化的知识管理系统。

以上就是NativeMind— 开源本地AI助手,智能对话、内容分析、写作辅助等的详细内容,更多请关注php中文网其它相关文章!

NativeMind的核心功能

NativeMind的核心功能